Hallo Community,

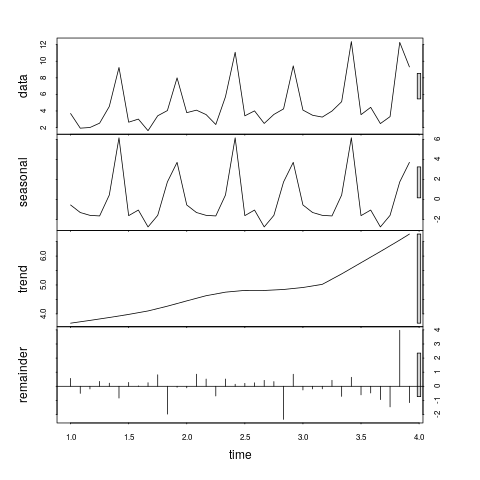

ich habe eine Reihe von Messwerten in zeitlicher Abfolge (lückenlos gemessen immer am Monatsersten). Zu diesen Messwerten habe ich ich die Regressionsgerade ermittelt und daraus resultierend die Abweichungen „Messwert vs (anhand Regressionsgerade) kalkulierter Wert“ ermittelt. So weit, so gut

Nun suche ich nach einem Weg, die Abweichungen zu analysieren, wobei mich folgendes interessiert:

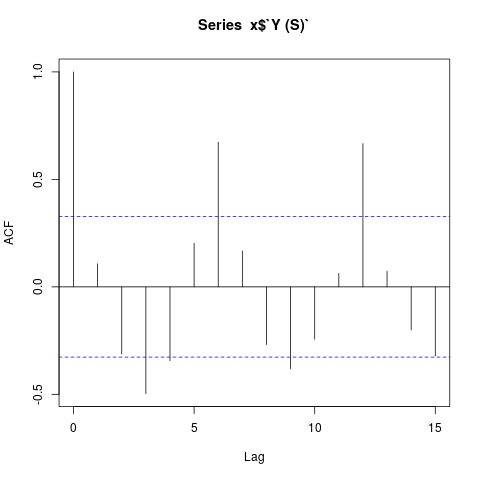

- Welche Monate fallen auf, weil sie regelmäßig „in die gleiche Richtung“ abweichen?

- Wie stark ist diese Abweichung?

- Sind diese Abweichungen signifikant oder möglicherweise zufällig?

Mein Ziel ist, nachher ein Modell (eine Formel, z.b. eine Modifzierte Regressionsgerade o.ä.) zu haben, welches auch die Schwankungen berücksichtigt, anhand dessen ich die Werte für die kommenden 12 Monate schätzen möchte. Ebenso möchte ich einen Wert haben, der mir sagt, wie genau dieses Modell auf die vorhandenen Messwerte zutrifft - was ich dann einfach als Indikator dafür hernehmen möchte, wie wahrscheinlich das auch als Prognose herhalten kann.

P.S. Ich hätte es gern möglichst einfach erklärt - ich bin zwar sehr interessiert an Mathematik, aber halt nur ein Laie

Vielen Dank vorab!